‘기능성 근적외선분광기’(fNIRS)의 모자형 뇌 혈류량 측정 장치. nirx.net

인공지능을 이용해 마음속에서 생각하거나 떠올리는 영상과 문자를 읽어내는 기술이 잇따라 등장하고 있다.

그동안은 뇌에 전극을 심어 뉴런이 내보내는 전기신호(뇌파)를 직접 잡아내 이미지와 단어를 예측했다. 이제는 강력해진 인공지능의 분석력을 바탕으로 뇌 영상 사진을 읽는(스캐닝) 것만으로도 무슨 생각을 하는지 알아내는 수준에 이르렀다. 상용화까지 가려면 더 많은 데이터 훈련과 기술 개발이 필요하지만, 말 그대로 ‘마음을 읽는 기술’이 가시화한 셈이다. 기술이 더 정교해지면 마비환자들이 간편하게 활용할 수 있는 소통 도구로 발전해갈 수도 있을 것으로 기대된다.

인공지능이 생각을 읽어내는 핵심 도구는 뇌 혈액의 산소 수치 변화를 측정하는 기능성 자기공명영상(fMRI)이다. 뇌의 어떤 영역이 활발하게 활동하면 그쪽으로 혈액이 많이 쏠리는 데 착안해, 이를 측정한 뇌 영상을 인공지능에게 훈련시켜 생각을 읽을 수 있도록 한 것이다.

뇌 영상은 전극 임플란트에 비해 속도가 느리고 정확성이 떨어진다. 뉴런의 활동에 따라 혈액 속의 산소 수치가 바뀌는 데는 약 10초가 걸린다. 하지만 뇌 전체를 높은 해상도로 종합 관찰할 수 있다는 이점이 있다. 따라서 여러 영역의 뉴런이 동원되는 높은 수준의 인지 기능을 파악하는 데 유리하다. 또 감염, 출혈, 발작 위험이 있는 임플란트 방식보다 훨씬 안전한 것도 장점이다.

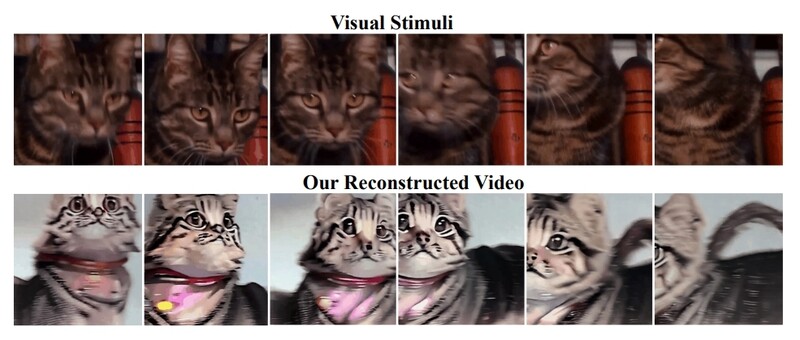

사람이 실제로 보고 있는 동영상(위)과 인공지능으로 뇌 사진을 해독해 완성한 영상(아래). 아카이브

싱가포르국립대와 홍콩 중문대 연구진은 뇌 영상과 인공지능의 이미지 생성 기술을 결합해 사람이 보고 있는 동영상과 거의 똑같은 영상의 비디오를 재현하는 데 성공했다고 최근 사전 출판논문 공유집 <아카이브>에 발표했다.

이 연구진은 지난해 말엔 사진을 재현하는 데 성공한 바 있다. 불과 몇개월 사이에 사진에서 움직이는 동영상으로 한 단계 더 나은 성과를 냈다.

당시 연구진은 먼저 뇌 스캐너로 수집한 데이터를 인공지능에게 훈련시킨 뒤, 이를 이미지 생성 인공지능인 스테이블 디퓨전과 결합해 사진을 생성했다. 이번 동영상 재현에도 비슷한 방식을 이용했다. 대신 개별 뇌 영상이 아닌 연속 영상을 훈련할 수 있도록 인공지능 모델을 보강했다.

연구진은 “인공지능이 내놓은 결과물은 원본 비디오와 완벽하게 일치하지는 않았지만 매우 근접했으며 색상도 일치하는 경우가 많았다”고 밝혔다.

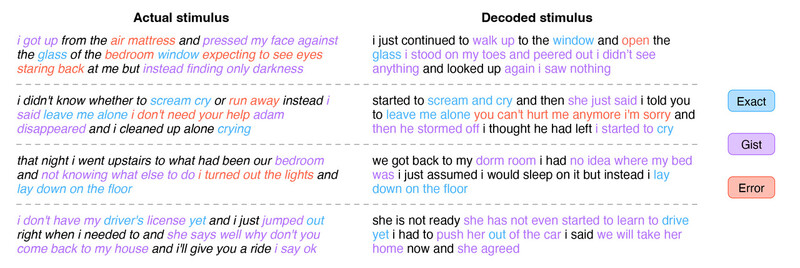

사용자가 들은 것과 뇌 영상 해독기가 예측한 것의 비교. 파란색은 단어를 정확히 맞힌 부분, 보라색은 요지를 맞힌 부분, 주황색은 잘못 해독한 부분이다. 오스틴 텍사스대 제공

인공지능을 이용해 생각을 말이나 문자로 표현해주는 기술도 선보였다.

미국 오스틴 텍사스대 연구진은 챗지피티(GPT)의 원형인 지피티 인공지능을 이용해 기능성 자기공명영상(fMRI)을 해독해 문자로 바꿔주는 ‘시맨틱 디코더’(semantic decoder) 시스템을 개발해 국제학술지 <네이처 뉴로사이언스>에 발표했다.

연구진은 실험 참가자 3명에게 16시간 분량의 인터넷방송과 라디오를 들려 주면서 뇌영상을 촬영했다. 이어 특정 단어나 문구가 나올 때 뇌 영상이 어떻게 달라지는지 분석해, 이를 인공지능에 학습시켰다. 사람의 뇌가 특정 단어나 문구에 어떻게 반응을 할지 예측하는 시스템과, 이전 단어를 토대로 다음 단어를 예측하는 시스템을 결합해 예측의 완성도를 높여갔다.

연구진은 ‘시맨틱 디코더’(의미 해독기)라는 명칭에서도 알 수 있듯, 이 기술은 단어 자체를 그대로 재생하기보다는 요지를 파악하는 데 특화돼 있다고 밝혔다. 예컨대 인공지능은 ‘나는 아직 운전면허증이 없습니다’라는 문구를 ‘그는 아직 운전 배우기를 시작하지 않았다’로 해독했다. 이는 에프엠알아이가 10초 단위로 뇌 영상을 찍기 때문이다. 연구진은 보통 영어 원어민의 경우 1초당 단어 2개를 말하는 점을 고려하면 20단어 안팎의 구문이 하나의 뇌영상에 담긴다고 볼 수 있다고 밝혔다.

그러나 뇌 영상을 읽는 동안 다른 생각을 하면 전혀 엉뚱한 결과가 나온다. 연구진은 따라서 이 기술의 성패를 가름하는 것은 사용자의 집중력이라고 말했다.

시맨틱 디코더는 실험 참가자들이 말을 하거나 듣는 상상을 할 때, 무성 애니메이션 영화를 볼 때 촬영한 뇌 영상에 대해서도 같은 해독 능력을 보였다.

앞서 올해 1월엔 영국 서섹스대 연구진이 뉴런의 전기신호(EEG)와 뇌 영상(fMRI) 데이터를 함께 인공지능에 훈련시켜 어떤 음악을 듣고 있는지 알아내는 기술을 국제학술지

<사이언티픽 리포츠>에 발표하기도 했다. 이 기술의 정확도는 72%였다.

인공지능을 이용해 마음 속에서 생각하거나 떠올리는 영상과 문자를 읽어내는 기술이 선보였다. 미국 오스틴 텍사스대 연구원이 실험참가자의 뇌 영상을 촬영할 준비를 하고 있다. 오스틴 텍사스대 제공

마비 환자의 소통 도구 기대…개인정보 침해 우려도

물론 인공지능으로 마음을 읽는 기술이 상용화하려면 아직 갈 길이 멀다. 우선 충분한 뇌 영상 훈련과 학습을 통해 판독의 정확성을 높여야 한다. 또 전문가들의 연구용이나 의료용으로 쓰는 값비싼 장비 대신 실제 생활 현장에서 사용할 수 있는 장비가 있어야 한다. 연구진은 해상도는 다소 낮지만 휴대가 가능한 ‘기능성 근적외선 분광기’(fNIRS)가 대안이 될 수 있을 것으로 보고 있다.

마음 읽기 기술은 정상적인 의사소통이 어려운 환자들에게 커다란 희소식이다. 이 기술을 이용하면 의식은 또렷하지만 온몸의 근육이 마비돼 말을 할 수 없는 사람들, 예컨대 뇌졸중 환자들도 다른 사람과 의사소통할 수 있다.

그러나 당사자의 동의나 허락 없이 생각을 훔칠 수도 있다는 점에서 악용 가능성도 배제할 수 없다. 오스틴 텍사스대 연구진은 “생물학적 데이터의 프라이버시를 보장하고 이 기술이 악의적으로 사용되는 것을 방지하기 위한 노력이 필요하다”고 지적했다. 다만 현재 기술 수준으로선 한 사람의 뇌 영상을 훈련한 인공지능이 다른 사람의 생각까지 읽지는 못하는 것으로 나타났다. 텍사스대 연구진이 실제로 시험을 통해 확인했다.

미국 하버드의대 가브리엘 라자로-무뇨즈 교수(생명윤리)는 <네이처>에 “정교하고 비침습적인 기술 개발이 우리가 예상했던 것보다 더 가까워진 것 같다”며 정책 입안자와 대중에게 큰 경각심을 가질 것을 주문했다.

듀크대 니타 파라하니 교수(생명윤리)는 <사이언스>에 “의사소통 능력이 필요한 사람들에겐 정말로 개벽할 만한 기술이지만 다른 사람들에게 미치는 영향은 심대할 것”이라고 말했다.

*논문 정보

https://doi.org/10.48550/arXiv.2305.11675Cinematic Mindscapes: High-quality Video Reconstruction from Brain Activity.

arXiv(2023)

https://doi.org/10.1038/s41593-023-01304-9Semantic reconstruction of continuous language from non-invasive brain recordings.

Nature Neuroscience(2023)

출처

뇌 스캔으로 비디오 재생

https://singularityhub.com/2023/05/26/an-ai-recreated-videos-people-watched-based-on-their-brain-activity

관련 논문

https://arxiv.org/abs/2305.11675

뇌 스캔으로 문장 재생

https://cns.utexas.edu/news/podcast/brain-activity-decoder-can-reveal-stories-peoples-minds

https://news.utexas.edu/2023/05/01/brain-activity-decoder-can-reveal-stories-in-peoples-minds/

https://newatlas.com/technology/mind-reading-ai-translates-brain-activity-into-text/?

https://www.vox.com/future-perfect/2023/5/4/23708162/neurotechnology-mind-reading-brain-neuralink-brain-computer-interface

https://www.nature.com/articles/d41586-023-01486-z?

https://www.smithsonianmag.com/smart-news/researchers-use-ai-to-decode-words-from-brain-scans-180982097/?

https://singularityhub.com/2023/05/02/this-brain-activity-decoder-translates-ideas-into-text-using-only-scans/?

https://www.science.org/content/article/scientists-use-ai-decipher-words-and-sentences-brain-scans?

https://theconversation.com/how-close-are-we-to-reading-minds-a-new-study-decodes-language-and-meaning-from-brain-scans-204691?

https://www.sciencealert.com/ai-experiment-decodes-brain-scans-to-reveal-things-people-are-thinking

네이처 뉴로사이언스 논문

https://www.nature.com/articles/s41593-023-01304-9

음악 재생

https://singularityhub.com/2023/04/06/this-researcher-knew-what-song-people-were-listening-to-based-on-their-brain-activity/?

논문 보기

https://www.nature.com/articles/s41598-022-27361-x

한겨레신문 선임기자. 미래의 창을 여는 흥미롭고 유용한 정보 곳간. 오늘 속에서 미래의 씨앗을 찾고, 선호하는 미래를 생각해봅니다. 광고, 비속어, 욕설 등이 포함된 댓글 등은 사양합니다.

한겨레신문 선임기자. 미래의 창을 여는 흥미롭고 유용한 정보 곳간. 오늘 속에서 미래의 씨앗을 찾고, 선호하는 미래를 생각해봅니다. 광고, 비속어, 욕설 등이 포함된 댓글 등은 사양합니다.